? 6 min

Naš planet samotna je točka u velikom sveobuhvatnom kozmičkom mraku. U našoj neprimjetnosti, u takvom bespuću, nema nagovještaja da će pomoć doći izvana da nas spasi od samih sebe.

Carl Sagan, Pale Blue Dot

Čovječanstvo stoji pred ponorom.

U nadolazećim stoljećima i tisućljećima imamo priliku uništiti bolesti, siromaštvo i nepotrebnu patnju. Možemo otkriti tajne svemira, stvarati umjetnička djela i činiti dobro u svemiru. Bila bi nezamisliva tragedija izgubiti ovu priliku.

Više puta smo imali bliski susret s izumiranjem i trenutno je rizik izumiranja vjerojatno najviši u povijesti zbog antropogenih rizika poput globalnog zatopljenja, neusmjerene umjetne inteligencije (eng. unaligned AI), nuklearnog rizika i rizika umjetnih pandemija.

U svojem jezivom magnum opusu, The Precipice, Toby Ord tvrdi da je smanjenje egzistencijalnog rizika među najvažnijim moralnim problemima današnjice, opisuje koji su rizici najveći i predlaže plan za budućnost čovječanstva.

Budućnost na kocki

Puno smo napredovali u pogledu ljudske dobrobiti tijekom proteklih desetljeća. Napretci u medicini, agrikulturi i tehnologiji smanjili su siromaštvo, glad i povećali općenite razine dobrobiti. Nije nezamislivo da ćemo u budućnosti moći potpuno istrijebiti probleme poput gladi i siromaštva. Budućnost bi mogla biti vrijeme blagostanja svjesnih bića svemira i imamo priliku to ostvariti.

Veličina dobra koje možemo ostvariti u svemiru je začuđujuća. Mliječna staza je sama po sebi ogromna i broj svjesnih bića koji bi se mogli u njoj nastaniti je za mnoge redove veličina veći od trenutnog broja na Zemlji. Broj ljudi koji su živjeli prije nas je oko 100 milijardi, ali broj ljudi koji bi mogli živjeti nakon nas je ogroman (jedna skromna procjena iz knjige Superintelligence Nick Bostroma je 1043 . To je jedinica s 43 nule nakon nje.)

Ako će u budućnosti postojati toliko ljudi i oni imaju moralnu vrijednost, to znači da je većina moralne vrijednosti u budućnosti. Dakle, najvažnija stvar koju možemo uraditi jest pokušati što bolje utjecati na dugoročnu budućnosti. Ovaj mentalitet zove se longtermism. Naravno, teško je predvidjeti utjecaj svojih odluka na budućnost, ali to ne znači da ne možemo barem pokušati. U riječima Orda,

Volja za ozbiljnim promišljanjem o nepreciznim vjerojatnostima besprimjernih događaja ključna je za suočavanje s rizicima prema budućnosti čovječanstva.

Uvelike zanemarujemo egzistencijalne rizike. Jedan iznimno bolan primjer je da

Međunarodna organizacija odgovorna za kontinuiranu zabranu bioloških oružja (the Biological Weapons Convention) ima godišnji budžet od samo 1.4 milijuna dolara – manje od prosječnog McDonald’s restorana.

Rizici

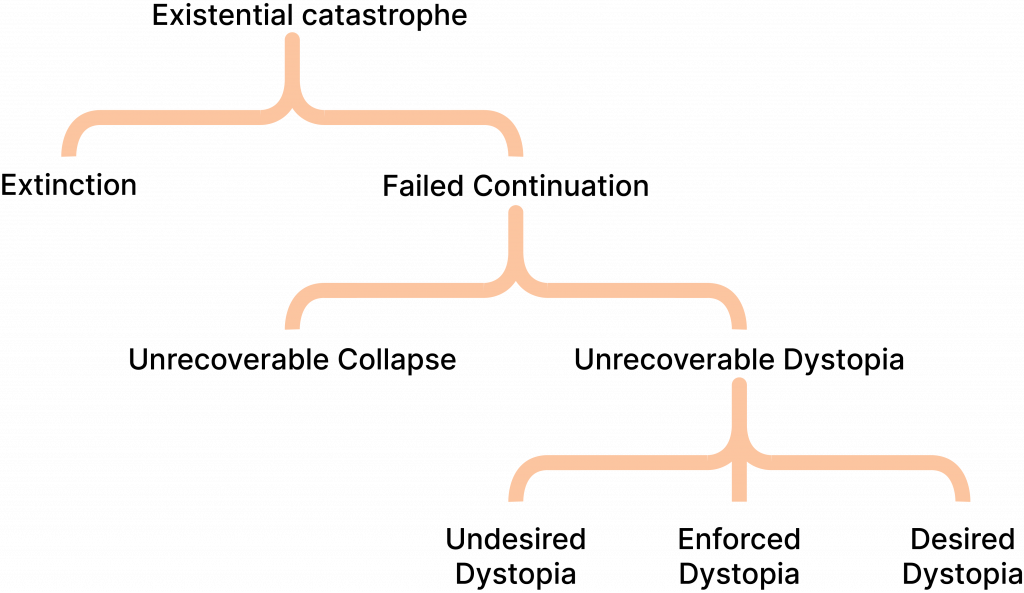

Toby Ord definira egzistencijalni rizik (ili ukratko x-rizik) kao rizik koji može uništiti dugoročni potencijal čovječanstva.

Rizici koji su prijetili čovječanstvu većinu povijesti, kao i svakoj drugoj vrsti na Zemlji, zovu se prirodni rizici. Stvari poput supervulkanskih erupcija, asteroida i supernova. Takvi rizici vjerojatno će nas pratiti još neko vrijeme, ali zbog njihove niske vjerojatnosti (kad se usporedi s drugim rizicima) nam ne bi trenutno trebali biti glavni prioritet.

Ord ima interesantan argument: tehnologije koje nam trebaju da spriječimo neke od tih rizika bi bile rizične. Postoji puno više asteroida koji skoro udare Zemlju od onih koji ju zapravo udare. Tehnologija za odbijanje asteroida mogla bi zaustaviti mali broj asteroida od udaranja Zemlje, ali bi, u krivim rukama, mogla pretvoriti mnoge bliske asteroide u oružja koja su više destruktivna od najjačih nuklearnih bombi na svijetu.

Rizici koji su rezultat ljudskih postupaka zovu se antropogeni rizici.

Nuklearni rizik je antropogeni rizik koji je zamračio drugu polovicu 20. stoljeća. Bilo je puno situacija u Hladnom ratu u kojima je sudbina svijeta ovisila o brzoj odluci jedne osobe. Imali smo sreću do sad, ali nitko nam ne garantira da ćemo zadržati tu sreću.

Klimatske promjene su možda atropogeni rizik koji će definirati nadolazeća desetljeća. Ordova najbolja predviđanja u vezi klimatskih promjena su tmurna, ali ističe da klimatske promjene nisu same po sebi velik ezgistencijalni rizik, nego faktor rizika – katalizator za druge rizike.

Budući rizici su egzistencijalni rizici koji će biti dopušteni napretcima u tehnologiji.

Umjetne pandemije su jedne od najopasnijih, i trenutno najpredočivijih, egzistencijalnih rizika. Trenutni sigurnosni standardi su nedovoljno strogi i nedovoljno primijenjeni. Više puta su iz laboratorija procurile bolesti koje su skoro uzrokovale pandemije.

Ord se ne brine primarno o curenju bolesti iz laboratorija, nego o umjetnim bolestima koje bi mogle biti ekstremno smrtonosne i zarazne. Koronavirus je svojom relativno niskom smrtnosti duboko utjecao na čovječanstvo. Učinak umjetne bolesti bi mogao biti puno gori.

Neusmjerena umjetna inteligencija je rizik koji Ord smatra najopasnijim. Ističe alignment problem, to jest problem stvaranja napredne umjetne inteligencije čiji su ciljevi usklađeni s ciljevima čovječanstva. Nemamo rješenje za problem usmjeravanja i razmak između istraživanja sigurnosti umjetne inteligencije i napredaka u umjetnoj inteligenciji se samo čini većim i većim.

Takav ishod ne mora uključiti izumiranje čovječanstva, ali mogao bi lako biti egzistencijalna katastrofa. Čovječanstvo bi zauvijek izgubilo kontrolu nad svojom budućnosti. Naša budućnost bila bi u rukama male skupine ljudi koji su postavili računalni sustav koji je preuzeo kontrolu. Ako imamo sreće, to bi vodilo do dobrog ili prihvatljivog ishoda, ali bismo isto tako mogli zauvijek zaključati duboko manjkavu ili distopijsku budućnost.

Put ka naprijed

U posljednjem dijelu knjige Ord izlaže grubi plan za budućnost čovječanstva koji je podijeljen u tri faze:

1. Dostizanje egzistencijalne sigurnosti

Ovaj korak zahtijeva da se suočimo sa egzistencijalnim rizicima i dosegnemo stanje egzistencijalne sigurnosti, gdje je egzistencijalni rizik nizak i takav ostaje.

2. Dugo razmišljanje (The Long Reflection)

Sljedeći korak je ramišljanje o odlukama koje bismo trebali napraviti u budućnosti.

Dugo razmišljanje prikazano je kao period u kojem je društvo stabilno, većina ljudskih potreba je ispunjeno i puno diskusije i razmišljanja se ulaže u važna pitanja poput:

- Koliko bi umjetna inteligencija trebala kontrolirati ljudske živote?

- Koliko bismo trebali promijeniti što to znači biti čovjek?

- Koliko je važna patnja neljudskih životinja i izvanzemaljaca?

- Bismo li trebali nastaniti cijelu galaksiju (ili svemir)?

- Bismo li trebali dopustiti starenju da ubija ljude?

Važno je prije velikih moralnih odluka sjesti i razmisliti, i važnost ovih odluka je ogromna. Pogriješiti na jednom takvom pitanju moglo bi uzrokovati ogromnu štetu u budućnosti bez lakog načina da ju spriječimo (naprimjer, ako nastanimo galaksiju septilijunima divljih životinja čiji su životi ispunjeni patnjom).

3. Ostvarenje našeg potencijala

Ovaj korak može pričekati dok ne saznamo što bismo zapravo trebali ostvariti. Još ne znamo što bi bio najbolji način oblikovanja budućnosti svemira. Glavni prioritet bi nam trebao biti ostvariti uvjete da drugi to saznaju. Možda smo rođeni prerano da svjedočimo čudesima koje će čovječanstvo ostvariti, ali živimo u vremenu gdje možemo utjecati na vjerojatnost njihovog ostvarenja.

The Precipice je na neki način spiritualni nasljednik knjizi Pale Blue Dot Carl Sagana, napisan u vremenu kada smo puno sigurniji u vezi opasnosti o kojima je Sagan mogao samo nagađati i puno svjesniji opasnosti koje su bile nezamislive kad je Sagan pisao.

Stojimo na ramenima divova. Ljudi koji su u svijetu ispunjenom zmajevima i duhovima pokušali stvoriti bolju budućnost. Baklja nam je predana i uz nju velika odgovornost. Dužnost prema onima koji su došli prije nas i onima koji će doći nakon nas – koji će nama biti kao leptir gusjenici.

Kamo sad?

Ako su vam se svidjele izložene ideje, strogo preporučujem da pročitate The Precipice (i Pale Blue Dot). Puno rada i razmišljanja o ovim problemima se događa u Effective Altruism zajednici (ali to uzmite s rezervom jer sam član dvaju EA organizacija).

Ako planirate čitati knjigu i voljeli biste o njoj raspravljati, preporučujem da se prijavite na čitateljski klub. Postoji čitateljski klub hrvatske grupe Efektivnog altruizma i Stanfordov čitateljski klub.